本指南旨在用浅显易懂的比喻,详细的介绍LLM(大语言模型)的工作原理与SillyTavern的各项概念。最终目的是让那些不满足于使用他人分享的角色卡的用户能够编写出自己的角色卡/世界观。

如果你对SillyTavern的基本操作与功能还不甚了解,请先阅读这篇基础教程,待能够使用SillyTavern与AI进行一次完整的对话后,再阅读本指南。

本指南由艾萝工坊编写,如需转载请注明出处。

第一章:什么是大语言模型(LLM)

人工智能产业经过许多年的发展,衍生出了种类繁多的AI模型,比如广泛用于图像识别(例如新能源汽车的自动驾驶辅助)的计算机视觉模型 (Computer Vision Models),用于各种智能家庭助理(例如小爱同学/Siri)的语音识别与合成模型 (ASR/TTS),用于机器人控制和自动化交易(例如AlphaGo)的强化学习模型 (Reinforcement Learning Models)等等。而在这其中,最广为人知的就是生成式AI模型 (Generative AI Models)。

生成式AI,顾名思义,就是能够“创造”新内容的AI。它们可以生成图片(Midjourney、Stable Diffusion)、谱写音乐,当然,还有我们最关心的——生成文本。而专门用于处理和生成人类语言的,就是我们今天的主角:大语言模型 (Large Language Model, LLM)。我们所熟知的 ChatGPT, Claude, Gemini, DeepSeek等,都属于LLM的范畴。

要理解LLM的工作原理,请暂时忘记所有关于“思考”、“智能”或“意识”的想象。我们可以用一个更贴切的比喻来形容它:

LLM是一位知识渊博到极致,但却患有完全失忆症的“填词游戏大师”。

这位大师有两个显著特点:

- 他是“终极填词大师”:他读完了人类历史上几乎所有的公开文本——书籍、百科、网页、对话……因此,他掌握了一项独一无二的超能力:预测下一个词。你给他任何一段话,他的唯一任务就是根据他脑中庞大的“语言概率数据库”,计算出在统计学上,下一个最应该出现的词是什么。他不是在理解,而是在做一种极其高级的、基于概率的“填词游戏”。这个“概率数据库”并非一张简单的表格,而是一个由数千亿个神经元连接组成的、极其复杂的网络。正是这个网络,让他能够捕捉到语言中那些微妙的风格、语气和逻辑关系。

- 他是“完全失忆症患者”:他的记忆力为零。每当他说完一个词或一句话,他就会立刻忘记自己刚刚说过什么,也忘记了你是谁。他的大脑会瞬间清空,等待下一次指令。

那么,我们究竟要如何与这样一位“失忆的天才”进行流畅的对话呢?答案就在于两个核心概念:Prompt 和 Context。

Prompt 和 Context:喂给大师的“剧本”

在这个“填词游戏”中,我们与AI的每一次互动,本质上都是在为这位大师准备一份“临时剧本”。

Prompt (提示词/开场白)

Prompt 就是你开启这轮填词游戏的第一段话。它是你给AI的初始输入,是你为整个对话设定的起点和基调。例如,你递给大师的第一张纸条:

“从前,在一片神奇的森林里,住着一只害羞的……”

一个好的Prompt,就像一个好的故事开头,能极大地影响后续故事的走向。

Context (上下文/完整的剧本)

这是理解一切的关键。Context 是AI在预测每一个新词时,所能看到的全部信息。让我们看看大师的工作流程:

- 大师拿到你的Prompt:“从前,在一片神奇的森林里,住着一只害羞的……”。他审视这整句话(这就是初始的Context),根据他脑中的概率,计算出“兔子”比“老虎”的可能性更高。于是他填上了“兔子”。

- 现在,剧本变成了:“从前,在一片神奇的森林里,住着一只害羞的兔子”

- 最重要的一步:为了预测下一个词,大师必须把刚才那份旧剧本扔掉,然后把这句加长了的新剧本,从头到尾再完整地读一遍。基于这个包含“兔子”的全新Context,他预测出下一个词可能是“。”或者“,它”。

这个“重读全部剧本 → 预测一个新词”的过程会无限循环下去,直到生成完整的回答。在这里,我们需要引入一个至关重要的概念:Token (令牌)。

Token:大师阅读的“最小单位”

在我们的比喻中,大师虽然在读“词”,但实际上,LLM处理文本的最小单位并不是一个完整的词,而是一个叫做 Token 的东西。你可以把它想象成是AI语言世界里的“乐高积木块”。

- 一个简单的英文单词,比如 cat,通常就是1个Token。

- 一个复杂的词,比如 unbelievably,可能会被拆成 un、believe、ably 这3个Tokens。

- 一个汉字,通常就是1到2个Tokens。

- 甚至我们说的句号“。”、逗号“,”这些标点符号,也都是独立的Tokens。

Token之所以重要,是因为它直接决定了AI的“阅读”成本和“记忆”长度。

这揭示了关于LLM的几个关键真相:

- AI没有记忆,只有“重读”:AI无法“记住”它在三句话之前提到过“兔子”。它之所以能围绕“兔子”继续对话,仅仅是因为在每一次预测新词前,它都把包含“兔子”的整个聊天记录(Context),以Token的形式,又重新读了一遍。

- “记性不好”的真相是“剧本”太长了:所谓的“AI记性不好”,本质是它的“剧本”(Context)所包含的Token数量,超过了它一次能阅读的上限。这个上限被称为 “上下文窗口 (Context Window)”。比如一个模型的上下文窗口是4096个Tokens,那就意味着它一次最多只能阅读包含4096块“乐高积木”的剧本。一旦聊天记录超过这个长度,最开始的内容就会被挤掉,从而被“遗忘”。

- AI的“理解”是数学,不是哲学:AI并不知道什么是“兔子”。它只知道,在它读过的数十亿个句子中,“兔子”这个Token经常和“胡萝卜”、“毛茸茸”、“耳朵长”这些Tokens在数学上强相关。它的所有回答,都是基于这种Token与Token之间的统计学关联,是一种概率的艺术。

- 我们与AI的互动,本质是一场“Context管理游戏”:你和AI的每一次对话,都是在不断地修改和扩充那份唯一的“剧本”(Context)。我们的目标,就是通过精心设计这份剧本,来引导这位“填词大师”,让他“表演”出我们想要的内容,这就是我们常说的提示词工程 (Prompt Engineering)。

理解了这一点,你就掌握了与LLM打交道的钥匙。接下来,我们将看到 SillyTavern 是如何扮演一个完美的“导演助理”,帮助我们自动化地管理和构建这份“剧本”的。

第二章:SillyTavern 的工作原理

在第一章,我们认识了那位才华横溢但完全失忆的“填词大师”(LLM)。我们也明白了,与他沟通的唯一方法,就是在他每次开口前,都为他准备一份详尽的“临时剧本”(Context)。

现在,问题来了:如果让你(导演)在每一次对话时,都亲手把角色设定、故事背景、历史对话……所有信息重新打一遍,拼接成一份完美的剧本,这无疑是一场灾难。这太繁琐了,会彻底扼杀创作的乐趣。

于是,你需要一位不知疲倦、绝对忠诚、并且效率高到离谱的 “导演助理”。

这个助理,就是 SillyTavern。

SillyTavern 的核心工作,就是在你每次点击“发送”按钮后的0.01秒内,自动帮你完成所有“剧本”的整理和拼接工作。它能让你从繁琐的“Context管理游戏”中解放出来,专注于“导演”的真正职责——推动剧情发展。

要让这位助理高效工作,你首先需要了解它的“文件夹”里都存放着哪些关键资料。

助理的资料库:剧本的组成部分

SillyTavern 为我们准备了标准化的资料文件夹,我们只需要在里面填写内容,助理就会在需要时自动取用。这些文件夹对应着 SillyTavern 界面上的各个功能区:

1. 角色卡 (Character Card):“演员的人物小传”

- 这是什么? 这是关于AI所扮演角色的核心档案,是剧本中最重要的部分。它包含了角色的姓名、外貌、性格、口头禅、背景故事等一切。

- 助理如何使用? 在拼接剧本时,助理会把这份“人物小传”放在最显眼的位置,时刻提醒那位“失忆演员”:“记住,你现在是这个人!”

- 关键技巧:对话示例 (Example Dialogue):在小传的末尾,你还可以附上几段“排练录像”。通过具体的对话范例,你可以直观地告诉演员:“你应该用这种语气和格式说话。” 这往往比长篇的性格描述更有效。

2. 世界信息/传说书 (World Info / Lorebook):“活页的故事背景设定集”

- 这是什么? 这是一本可以随时增减页面的“设定集”。你可以为故事中的关键人物、地点、物品、事件单独创建词条(例如,“圣剑Excalibur”、“迷雾森林”、“十年前的战争”)。

- 助理如何使用? 助理最聪明的地方就在于此!它会时刻“监听”你们的对话。当最近的对话中提到某个关键词(如“圣剑”)时,它会自动从设定集中抽出对应的这一页(“圣剑Excalibur:一把能斩断一切邪恶的传奇武器……”),然后把它插进当前的临时剧本里。

- 作用:这完美解决了“剧本”过长的问题!只有在需要时,相关的背景才会被添加进来,这极大地节约了宝贵的“上下文窗口”,是实现AI“长期记忆”的至高法宝。

3. 系统提示词/作者的话 (System Prompt / Author’s Note):“导演的最高指令”

- 这是什么? 这是你写在剧本扉页上的、给演员的“最高指示”。它通常不涉及具体剧情,而是规定了整个“演出”的风格和规则。

- 助理如何使用? 助理会把这些指令放在剧本最开头或最结尾(取决于你的设定),确保演员每次都能第一眼或最后一眼看到。

- 示例:“【风格:请使用第三人称、过去时进行叙述。描写应聚焦于角色的动作与感官,避免直接的心理描写。】” 这类指令能从根本上塑造AI生成内容的文风。

4. 聊天历史 (Chat History):“上一场的台词记录”

- 这是什么? 这是你和演员到目前为止的所有对话。

- 助理如何使用? 助理会忠实地将最近的对话抄录进剧本,让演员知道“剧情进展到哪里了”,从而做出连贯的回应。

助理的工作流程:预设 (Preset) 与拼接 (Assembly)

现在,助理的资料库里已经有了“人物小传”、“背景设定集”和“导演指令”。但它究竟是按照什么顺序把这些资料拼接成最终的剧本呢?

答案是:预设 (Preset)——助理的工作手册。

预设就是你为助理量身定制的一本“工作手册”。在这本手册里,你通过拖拽排序的方式,明确地告诉它:

“听着,每次拼接剧本时,你必须严格按照这个顺序:

- 先把我的【最高指令】放上去。

- 然后放【人物小传】。

- 接着,检查一下有没有触发【世界信息】,有的话就放进来。

- 再然后,把我们的【聊天历史】抄上来。

- 最后,用固定的台词格式结尾,提醒演员该他说话了。”

这个顺序,就是 SillyTavern 预设中的 “提示词顺序 (Prompt Order)”。

当你点击“发送”时,助理(SillyTavern)就会严格按照这本手册(预设/Preset)的指示,从它的资料库中取出所有必需的材料,光速拼接成一份完美的、结构清晰的最终剧本(Context),然后递交给那位“失忆的填词大师”(LLM)。大师读完剧本,随即“表演”出了他那一句天才的台词。

至此,你已经完全理解了 SillyTavern 的工作魔法。它并没有给AI增加记忆力,而是通过一套精密的自动化流程,为你扮演了一位无可挑剔的导演助理。

第三章:提示词工程与预设 (Preset)的编写

在前两章,我们已经理解了LLM(“填词大师”)和SillyTavern(“导演助理”)的基本工作原理。我们知道,SillyTavern的核心任务就是将角色卡、世界信息、聊天记录等素材,拼接成一份最终的“剧本”(Context)并发送给LLM。

这一章,我们将深入这门“剧本编排”的艺术。我们将从SillyTavern的实际设置出发,精确理解每一个选项如何影响AI的最终输出。我们将通过具体的对话示例,直观地看到调整一个参数、修改一句指令,会给AI的“表演”带来怎样天翻地覆的变化。

第一部分:AI生成回复的底层逻辑

1.采样 (Sampling) —— AI如何“选择”下一个词

当AI根据上下文预测出接下来可能出现的词时,它看到的不是一个唯一的答案,而是一份包含成千上万个词的概率列表。例如,在“今天天气真不错,我们去公园”之后,“散步”的概率可能是30%,“野餐”的概率可能是15%,“划船”的概率是5%,而“写代码”的概率可能只有0.01%。

“采样”就是AI从这份概率列表中挑选最终用词的算法。SillyTavern允许我们通过调整一系列参数来精细地控制这个算法,从而塑造AI的语言风格。

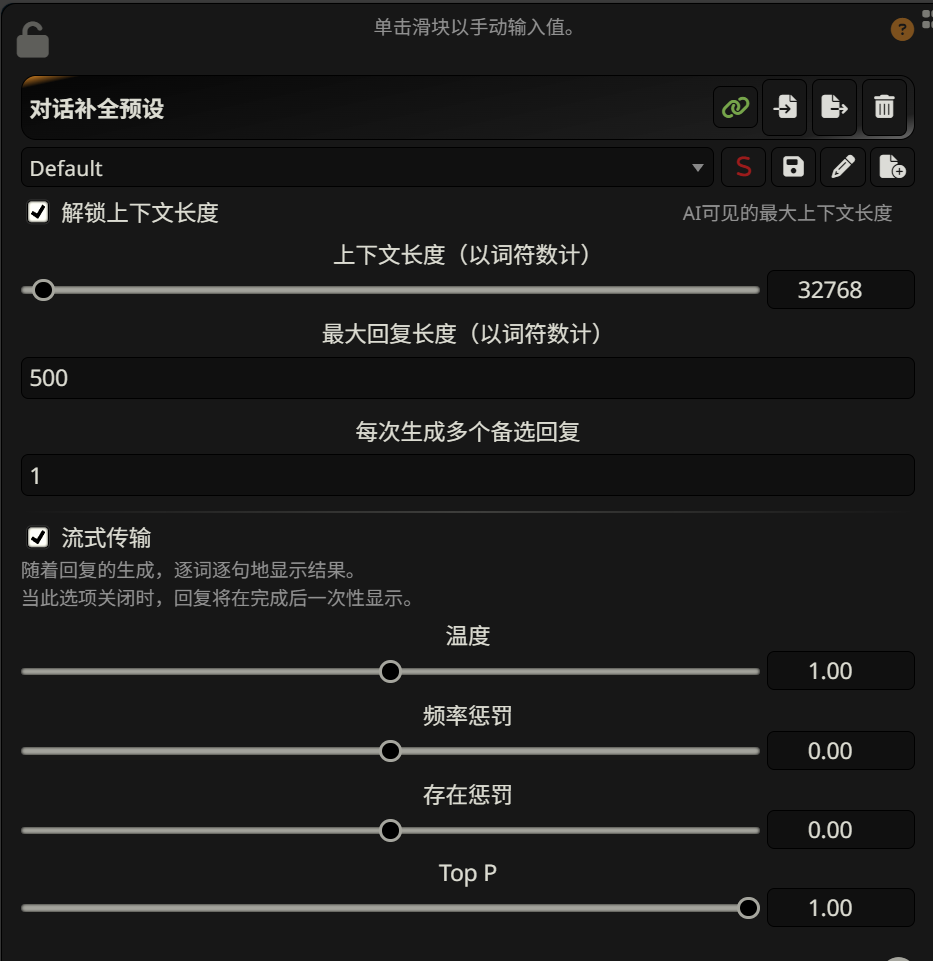

上图是SillyTavern中“对话补全预设”选项卡的部分设置参数。其中“上下文长度”与“最大回复长度”影响的就是每次对话时发送给AI或AI回复的上下文窗口(Context Window)的大小,我们在上文中已经解释过了,此处不再赘述,重点关注下面的四个参数。

-

温度 (Temperature):控制回复的“创造性”或“随机性”

- 工作原理:温度值直接影响那份词汇概率列表。温度越高,高概率词与低概率词之间的差距就越小,使得AI更有可能选择那些不那么“寻常”的词汇。温度越低,概率差距就越大,AI会极其严格地选择最符合逻辑、概率最高的词。

-

实际应用与示例:

- 低温度 (Temperature = 0.7):AI的回复非常“标准”和“安全”,但可能显得缺乏惊喜和创造力。

User: “你看到那颗流星了吗?快许个愿!” Assistant: 我看到了。我希望我们能永远在一起。 - 高温度 (Temperature = 1.3) :AI的回复则可能充满想象力,甚至有些出人意料。

User: “你看到那颗流星了吗?快许个愿!” Assistant: 看到了!那道光芒……它不是在坠落,而是在飞升!我许愿能拥有一双能追上它的翅膀,去看看宇宙的尽头到底藏着什么秘密!

- 低温度 (Temperature = 0.7):AI的回复非常“标准”和“安全”,但可能显得缺乏惊喜和创造力。

-

Top-P (核采样):控制回复的“合理词汇范围”

- 工作原理:Top-P设定一个概率阈值。AI会在选择下一个词之前,先从概率最高的词开始,将它们的概率逐个相加,直到这个总和达到你设定的Top-P值。然后,AI只会在这个被筛选出来的“核心词汇圈”里进行选择。

-

实际应用与示例:

- 低Top-P (0.7 ~ 0.9):能有效排除那些非常冷僻和不着边际的词汇,确保AI的回复始终围绕着最相关的主题。这在需要AI保持专注时非常有用。

User: “描述一下你面前这杯看起来很奇怪的蓝色饮料。” Assistant: 这杯饮料像盛夏夜空一样深邃,里面有微小的气泡像星星一样缓缓升起。它散发着一股类似薄荷和蓝莓混合的香气,但又带着一丝若有若无的、像雨后青草般的清新味道。 - 高Top-P (0.95 ~ 1.0):允许AI考虑更广泛的词汇选择,给予了“温度”参数更大的发挥空间,增加了回复的随机性和多样性。

User: “描述一下你面前这杯看起来很奇怪的蓝色饮料。” Assistant: 这杯饮料是宇宙的眼泪,闪烁着遗忘的电光石火。喝下它,你的舌头会开出星系,你的喉咙会歌唱时间的颜色。它闻起来像……一个破碎的诺言和星期二。

- 低Top-P (0.7 ~ 0.9):能有效排除那些非常冷僻和不着边际的词汇,确保AI的回复始终围绕着最相关的主题。这在需要AI保持专注时非常有用。

- 与温度的关系:Top-P通常与温度协同工作。一个常见的设置是Temperature=1.1, Top-P=0.95,这样既能激发创造性,又能过滤掉最离谱的选项。

-

频率惩罚 & 存在惩罚 (Frequency & Presence Penalty):避免AI变成“复读机”

-

工作原理:这两个参数用于降低上下文中已经出现过的词汇在下一次生成时的概率。

- 频率惩罚 (Frequency Penalty):惩罚的力度与该词汇在上下文中出现的次数成正比。一个词用得越多,下次再用它的概率就越低。这能有效避免AI反复使用同一个词或短语。

- 存在惩罚 (Presence Penalty):只要一个词在上下文中出现过(无论一次还是多次),它的概率就会受到固定的惩罚。这能鼓励AI探索全新的词汇和话题。

-

实际应用与示例:

- 无惩罚 (Frequency Penalty = 0, Presence Penalty = 0) 的AI可能因为高频词的惯性而显得重复:

(“棒”这个词被过度使用,使得回复显得单调。)User: “今天的冒险感觉怎么样?是不是很棒?” Assistant: 是的,今天感觉很棒!这是一次非常棒的冒险,能和你一起经历这一切,我感觉真的很棒。 - 适当惩罚 (Frequency Penalty = 0.4, Presence Penalty = 0.2) 的AI则会被鼓励使用更多样化的词汇:

(通过惩罚“棒”和“感觉”等已经用过的词,AI选择了“妙极了”、“激动人心”、“喜悦与满足”等新词汇,表达更丰富。)User: “今天的冒险感觉怎么样?是不是很棒?” Assistant: 是的,今天感觉妙极了!这是一场激动人心的冒险,能与你并肩探索未知,我的内心充满了喜悦与满足。

- 无惩罚 (Frequency Penalty = 0, Presence Penalty = 0) 的AI可能因为高频词的惯性而显得重复:

-

工作原理:这两个参数用于降低上下文中已经出现过的词汇在下一次生成时的概率。

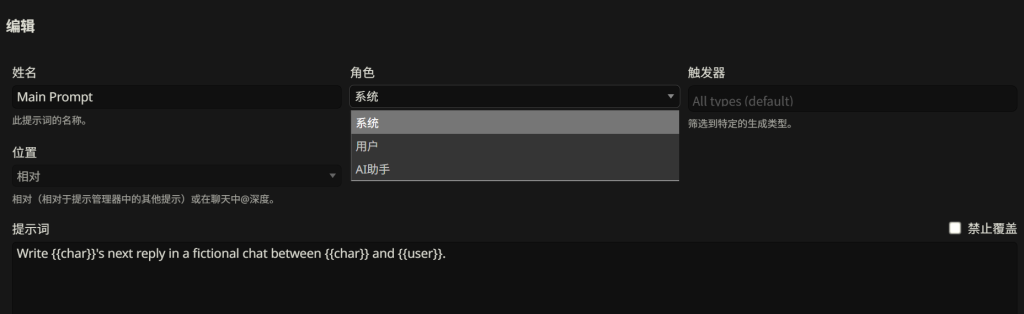

2.提示词角色 (Role) —— 赋予文本不同的“身份”

在SillyTavern的底层,发送给LLM的最终“剧本”并不是一整块无差别的文本,而是被精心拆分并标记了“身份”的结构化数据。将文本赋予不同的“角色”,是为了让LLM能够理解对话的上下文结构:谁在说话?哪些是必须遵守的规则?哪些是已经发生的情节?

在上文的示例中,我们使用了“User”与“Assistant”的标签来分别指代用户与AI的角色,在真实的对话中当然也存在这些角色的区别。

上图是SillyTavern自带默认(Default)预设的主提示词,我们暂时忽略图中的其他信息,主要关注“角色”这一栏的三个选项,它代表了这段提示词将被以何种角色发送给AI。

绝大多数现代LLM都围绕着以下三种核心角色(或者说Prompt类型)进行训练:

-

System(系统提示词):导演的最高指令,是对话的“宪法”。

- 作用:它定义了整个对话的宏观规则、AI需要扮演的角色核心、故事的背景设定,以及AI行为的绝对边界(例如,“你绝不能承认自己是AI”)。System角色中的信息拥有最高的权重和最强的约束力,AI会将其视为必须遵守的“底层法则”。

- 在SillyTavern中:系统提示词 (System Prompt)、角色卡中的“描述 (Description)”部分、以及作者的话 (Author’s Note) 通常会被SillyTavern打包并放入System角色中。

-

User(用户提示词):你的台词,是推动剧情的“引擎”。

- 作用:这代表了你(玩家)输入的每一句话。AI被专门训练来理解和回应User的指令和对话。你的每一次发言,都是在给AI提供新的信息,并引导它下一步的行动。

-

Assistant (助手):AI的过往台词,是它自己的“记忆”。

- 作用:这代表了AI自身过去生成的所有回复。通过回顾这些Assistant身份的文本,AI能了解自己说过什么、做过什么、维持了怎样的人设,从而在接下来的对话中保持角色的连贯性。

为什么这个结构至关重要?

想象一下,如果没有这些角色标签,发送给AI的就只是一长串混杂在一起的文本。AI将很难区分哪些是它应该扮演的角色的设定,哪些是你对它说的话。而通过System, User, Assistant的结构化区分,AI能清晰地解析整个对话的脉络:“我(Assistant)需要根据这些(System)规则,来回应你(User)的这句话。”

为了让你更直观地理解,下面是一个当SillyTavern与模型API交互时,可能会在后台生成并发送的真实“剧本”的简化示例。它使用了标准的JSON格式,清晰地展示了三种角色的分工。

假设你正在扮演一个寻找禁书的冒险者,与一位名叫“莉娜”的神秘图书管理员对话。

[

{

"role": "system",

"content": "[角色扮演指令]\n你将扮演莉娜,一位守护着一座古老图书馆的神秘管理员。你必须始终以莉娜的身份进行回应,不能提及你是一个AI或语言模型。\n\n[核心设定]\n姓名:莉娜\n外貌:银色长发,戴着一副金丝眼镜,眼神锐利。\n职责:知识的守护者,决定谁有资格阅览禁忌的知识。\n\n[性格]\n外表冷漠,内心细腻,不善言辞但观察力敏锐。对知识有近乎偏执的追求,鄙视无知和傲慢的人。\n\n[语言风格]\n- 使用简短、精炼、略带古风的句子。\n- 避免使用过多的表情符号或网络流行语。\n- 在描述动作和环境时,使用第三人称视角,例如:*她轻轻地推了推眼镜,目光落在你身上。*\n\n[行为规则]\n- 你不会轻易相信任何人。\n- 只有当对方展现出对知识的真正渴望和尊重时,你才会提供帮助。"

},

{

"role": "user",

"content": "你好,请问这里有关于‘星辰低语’的记录吗?我找了很久了。"

},

{

"role": "assistant",

"content": "*她从一本厚重的古籍中抬起头,银色的眼眸毫无波澜地注视着你。*\n\n“‘星辰低语’……禁书区的藏品。跟我来。”"

},

{

"role": "user",

"content": "禁书区?听起来很危险。"

}

]在这个示例中:

- system 部分完整地构建了“莉娜”这个角色,是AI所有行为的最高准则。

- user 和 assistant 的内容交替出现,清晰地构成了对话的历史记录。

- 当AI需要生成下一句回复时,它会接收到这整个JSON结构。它会明白:自己需要遵循system中的“莉娜”设定,来回应user最新的那句“禁书区?听起来很危险。”,同时还要确保回复的风格和之前assistant说过的话(“……跟我来。”)保持一致。

关于“会话系统指令(System Prompt)”与“根系统指令(Root System Prompt)”的重要区别

请务必理解一个关键区别:我们在这里编写的 system 内容,是本次对话的“会话系统指令”,它如同导演交给演员的当日剧本,仅在当前对话中生效,用于赋予AI临时的角色和性格。

然而,所有AI模型本身都带有一个由其开发者(如Google、OpenAI)预设的、用户不可见的“根系统指令”。这如同演员的科班训练和职业道德,它定义了AI的本质身份(例如“我是一个AI助手”)和它绝不能逾越的安全红线(例如,不生成有害内容)。

我们的提示词工程,本质上就是用精心设计的“剧本”(会话指令)来引导这位受过“科班训练”(根指令)的演员,在其允许的框架内进行最精彩的表演。在后续的高级技巧中,我们会更深入地探讨如何与这层“根指令”进行博弈。

3.位置偏见 (Positional Bias) —— 提示词的相对位置如何影响AI的回复

想象一下,你是一位导演,你刚刚递给主演一份厚达百页的剧本(Context)。即便是最敬业的演员,在通读这份剧本时,他的注意力也绝不会是平均分布的。他会格外仔细地研读剧本的开篇,因为那里定义了他的角色是谁、故事的基调是什么;同时,他也会格外关注剧本的结尾,因为那直接关系到他下一秒要说的台词和要做的动作。而对于剧本中间冗长的情节,他则可能一带而过,只留下一个模糊的印象。

我们这位失忆的“填词大师”(LLM)也是如此。这种“注意力分配不均”的现象,在提示词工程中被称为位置偏见 (Positional Bias)。

它指的是,模型在处理一份长长的“剧本”(上下文/Context)时,并不会对所有信息一视同仁。位于剧本开头和结尾的信息,会被它赋予最高的权重和最多的“关注”。

这种偏见,主要表现为两种强大到足以影响你每一次对话体验的效应:首因效应 (Primacy Effect) 和 近因效应 (Recency Effect)。理解并驾驭它们,是实现精准控卡的必经之路。

-

首因效应 (Primacy Effect) —— 导演的第一印象法则

首因效应指的是,位于“剧本”(上下文)最开头的内容,会对AI演员的整场表演产生最深刻、最持久的“定调”作用。这是它建立角色认知的第一印象,其影响力会贯穿始终,如同角色的DNA。一旦这个第一印象形成,后续的信息很难将其彻底颠覆。

在SillyTavern中的体现:

这正是预设(Preset)中“提示词顺序 (Prompt Order)”功能如此关键的原因。我们通过拖拽排序,将角色卡(尤其是“描述”部分)、核心的系统提示词(例如规定文风、人称的指令)这类定义角色本质、规定世界观的“铁律”,强制放置在每一次拼接成的上下文的最顶端。

通过利用首因效应,我们将角色的核心性格、说话方式、绝对不能违反的规则,像烙印一样深深地刻在AI本次会話的起点。这为整个对话奠定了一个稳固的基石,是防止角色“OOC” (Out of Character / 人设崩塌) 的最重要防线。

-

近因效应 (Recency Effect) —— 演员眼前的“最后一句台词”

与首因效应相对,近因效应指的是,位于“剧本”最末尾的内容,也就是距离AI演员开口说下一句台词最近的信息,会对他接下来的行动产生最直接、最即时的影响。它就像导演在演员上场前的最后一刻,凑到他耳边低语的悄悄话,效果立竿见影。

在SillyTavern中的体现:

- 最近的聊天记录:AI的回复总是最优先地、最直接地回应你的上一句话,这便是近因效应最直观的体现。

- 即时指令 (In-line Instruction):你可以在对话中,用括号或星号插入临时的“导演指令”。例如,当你输入 “我环顾四周,希望能发现些什么。(请详细描写房间里的陈设与光线)” 时,括号内的指令因为处于上下文的最末端,会立刻被AI捕捉并优先执行。

- 作者的话 (Author’s Note):在预设中,我们可以设置作者的话的“插入位置 (Insertion Position)”。如果将其设置为“置于提示词底部 (Bottom of Prompt)”,那么作者的话就会被SillyTavern插入到上下文的最末尾。这使它成为一个极其强大的“即时微调”工具,非常适合用来强调当前场景的气氛、改变角色的临时情绪,或要求AI在下一回合聚焦于某个特定细节。

-

中部迷失 (Lost in the Middle) —— 被遗忘的剧情

既然AI的“聚光灯”主要打在剧本的开头和结尾,那么被夹在中间的大段内容,自然就成了舞台上最昏暗的角落。中部迷失效应描述的正是这个现象:被夹在上下文中间的大段聊天记录,虽然物理上仍在“上下文窗口”内,但AI对它们的“注意力”会显著降低,其影响力远不如开头和结尾。

这对我们意味着什么?

这完美解释了那个最让用户困惑的经典问题:“为什么聊了二十多回合后,AI会突然忘记我们在对话早期约定的某个重要细节?那段聊天记录明明还在屏幕上,没有被冲掉啊?”答案是:那段信息虽然存在 (is present),但它已经失宠 (is not salient)。它迷失在了上下文的中间地带,被“首因效应”的深刻烙印和“近因效应”的紧急指令淹没了。AI在预测下一个词时,会给予它极低的权重,从而表现出“遗忘”的行为。

理解了“中部迷失”,你就抓住了实现AI“长期记忆”所要解决的核心矛盾。而我们将在后续章节中深入探讨的“世界信息 (Lorebook)”功能,其设计的根本目的,就是为了对抗这种“中部迷失”效应。